前言

在近年来,随着深度学习技术的快速发展,许多强大的大语言模型(LLM)被广泛应用于各个领域。而这些模型通常需要巨大的计算资源和存储空间。幸运的是,借助像 Ollama 这样的工具,普通电脑用户也能运行一些优秀的大语言模型,例如 DeepSeek-R1。本篇文章将介绍如何在普通电脑上使用 Ollama 运行 DeepSeek-R1 大语言模型,并分享一些实用的技巧和注意事项。

什么是 Ollama?

Ollama 是一个旨在简化大语言模型部署的工具。它提供了一个简洁的接口,使得开发者和研究人员可以在本地机器上快速运行和测试各种流行的语言模型。它支持多种模型和框架,并且优化了性能和内存管理,使得即便是普通电脑用户也能体验到强大的大语言模型。

官方网站:https://ollama.com/

什么是 DeepSeek-R1?

DeepSeek-R1 是一款基于 Transformer 架构的大语言模型,它在多项自然语言处理任务中表现出色,特别是在文本生成和理解方面。DeepSeek-R1 采用了先进的模型压缩技术,使其能够在更低的计算资源下运行,同时仍然保持较高的精度和表现。该模型尤其适用于文本生成、问答、对话系统等应用场景。

官方网站:https://www.deepseek.com/

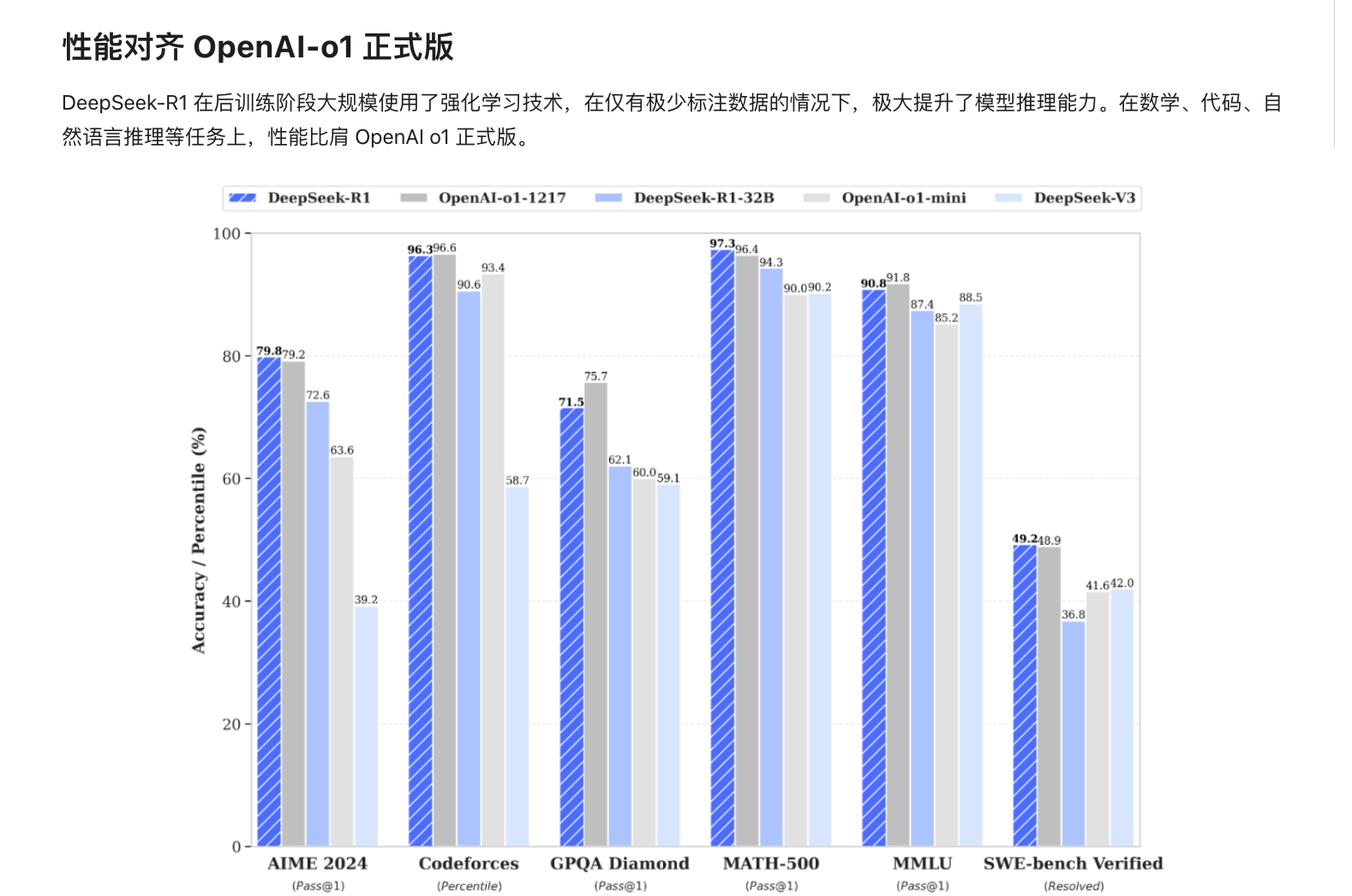

性能

DeepSeek影响力

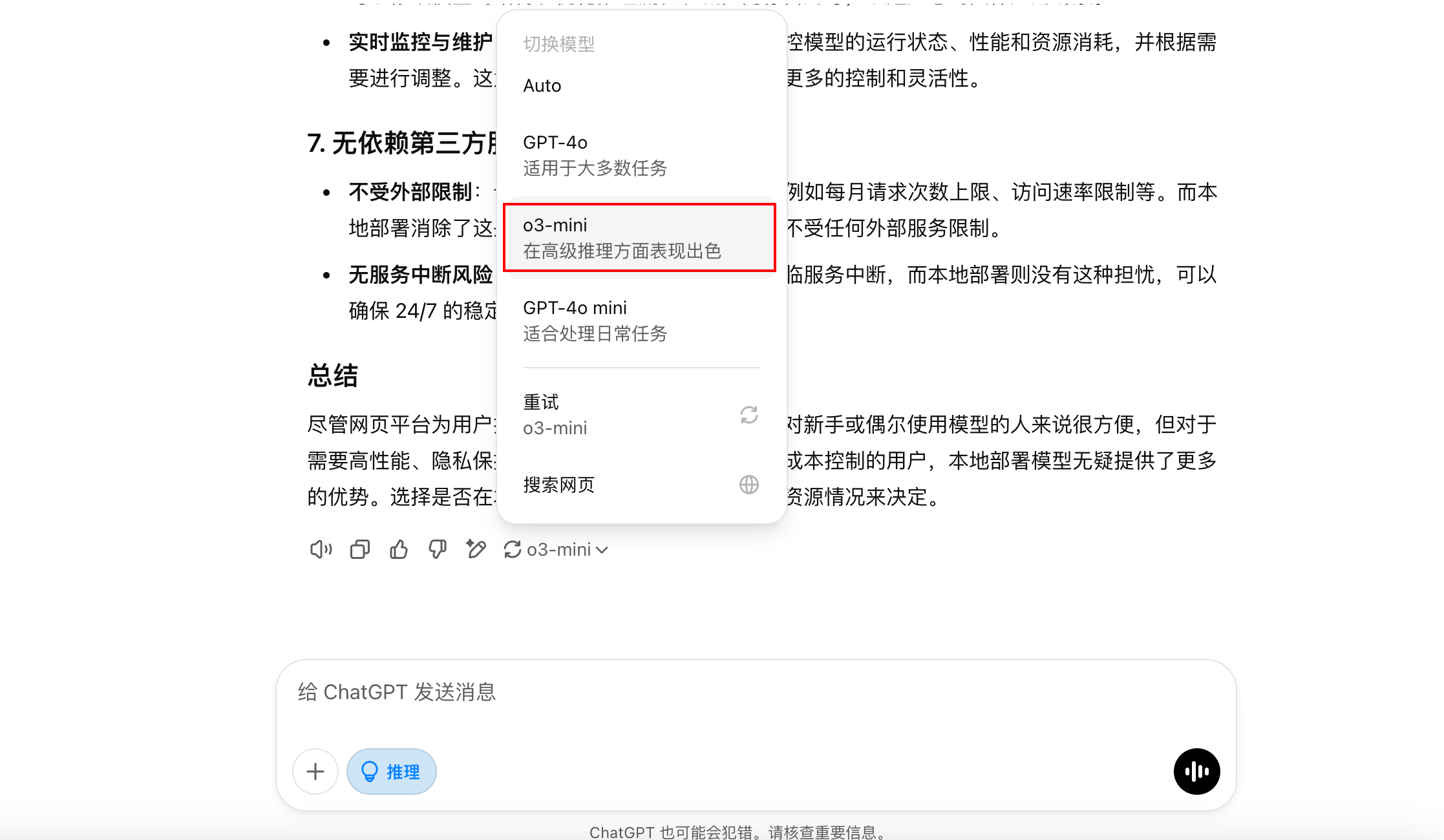

受DeepSeek影响?OpenAI上线O3 Mini,推理模型首次免费

随着DeepSeek发布的开源模型震撼全球,OpenAI的这款新品备受关注。o3-mini支持开发者调整“AI推理努力程度”,分为低、中、高三个级别。o3-mini能够以更低的成本、更快的响应速度,为用户提供STEM能力,在科学、数学和编程领域表现尤为出色。在2024年美国数学邀请赛的测试中,在最高努力水平时,o3-mini的准确率提升至87.3%。在博士级科学问题方面,在最高努力水平时,准确率接近80%。

电脑配置

测试电脑配置如下

Mac电脑

windows电脑

Linux系统

使用的飞牛云NAS测试

为什么要本地部署

虽然直接在网页上使用大语言模型如 DeepSeek-R1 或 Ollama 是一种便捷的方式,但本地部署仍然有其独特的优势。以下是一些选择本地部署而非仅仅在网页上使用的理由:

- 性能和响应速度

低延迟:本地部署模型可以减少网络延迟,直接通过本地硬件处理请求,比通过远程服务器获取响应更快。

资源利用:本地部署可以充分利用本地的计算资源(例如高性能 GPU),显著提高推理速度,尤其是在需要高频繁或实时响应的应用中。 - 隐私和数据安全

数据控制:本地部署模型意味着数据始终留在本地,避免了将敏感数据上传到云服务器的风险。对于需要保护隐私的行业(如医疗、金融等),数据不出本地是一个至关重要的考量。

合规性:许多行业或地区对数据的存储和传输有严格的法律要求。在本地运行可以确保符合当地的隐私和数据保护法规,如 GDPR 等。 - 定制和灵活性

自定义模型:本地部署让您能够根据需要定制模型的行为或进行训练和微调。您可以根据特定需求调整模型架构,或添加专门的数据集进行训练。

更好的控制:本地运行模型时,您可以对模型的资源分配、计算精度(如 FP16 等)、批量处理等进行精细化控制,从而提高性能或节省计算资源。 - 成本控制

避免订阅费用:许多云平台提供的大语言模型需要付费,且费用通常基于使用的资源(如处理能力、API 请求数等)计算。对于长期使用,云服务的费用可能会积累成一笔可观的开销。通过本地部署,您仅需要购买一次硬件设备(如 GPU)并且不需要持续支付使用费。

减少云存储和带宽成本:上传和下载大模型或处理大量数据时,可能会产生额外的带宽和存储成本。通过本地部署,您可以避免这些费用。 - 离线访问

无网络限制:本地部署不依赖于外部服务器,因此您可以在没有互联网连接的情况下使用模型。这对于在边远地区或网络环境不稳定的情况下仍然需要使用大语言模型的场景非常有用。

持续可用性:即使云服务提供商的服务器出现故障或中断,您本地的部署仍然可用,减少了依赖单一外部服务的风险。 - 自我管理与优化

自主调试与优化:本地部署允许您根据特定的硬件配置和需求对模型进行调试、优化和调整。您可以修改模型的结构、优化推理流程、减少内存占用等,以适应您的具体应用场景。

实时监控与维护:在本地环境中,您可以实时监控模型的运行状态、性能和资源消耗,并根据需要进行调整。这为高负载运行和长期部署提供了更多的控制和灵活性。 - 无依赖第三方服务

不受外部限制:云服务的 API 可能会出现限制,例如每月请求次数上限、访问速率限制等。而本地部署消除了这些限制,您可以按需使用模型,不受任何外部服务限制。

无服务中断风险:云服务商可能会进行维护或面临服务中断,而本地部署则没有这种担忧,可以确保 24/7 的稳定使用。

VPS推荐

如需要vps的可以查看以下地址

点我直达莱卡云官网

香港VPS

香港Colo数据中心,3C直连,平均延时30+ms,免备案

| 名称 | CPU | RAM | 硬盘 | 带宽 | 月流量 | 价格 | 购买链接 |

|---|---|---|---|---|---|---|---|

| 香港BGP 标配版 | 1C | 1G | 30G | 3Mbps | 无限 | 22 元/月 | 点我购买 |

| 香港BGP 限量款 | 2C | 4G | 30G | 3Mbps | 无限 | 25 元/月 | 点我购买 |

| 香港BGP(弹性) | 2 – 16C | 4 – 32G | 30 – 400G | 3 – 20Mbps | 无限 | 22 元/月起 | 点我购买 |

香港Mega Two数据中心,三网CN2 GIA优化,实现全国超低延迟。

| 名称 | CPU | RAM | 硬盘 | 带宽 | 月流量 | 价格 | 购买链接 |

|---|---|---|---|---|---|---|---|

| 香港CN2 GIA 标配版 | 1C | 1G | 20G | 3Mbps | 无限 | 30 元/月 | 点我购买 |

| 香港CN2 GIA(弹性) | 2 – 32C | 2 – 128G | 40 – 700G | 3 – 30Mbps | 无限 | 48 元/月起 | 点我购买 |

日本VPS

日本服务器介绍

电信去程163,回程CN2,移动联通双程骨干直连,宽带质量优秀。

| 名称 | CPU | RAM | 硬盘 | 带宽 | 月流量 | 价格 | 购买链接 |

|---|---|---|---|---|---|---|---|

| 日本CN2(弹性) | 1 – 16C | 1 – 16G | 20-200G | 5 – 20Mbps | 不限流量 | 46 元/月起 | 点我购买 |

| 日本CN2大带宽(弹性) | 1 – 16C | 1 – 16G | 20-200G | 20 – 50Mbps | 500G/月 | 55 元/月起 | 点我购买 |

韩国VPS

韩国服务器介绍

韩国CN2优化线路,大陆访问快速响应,电信CN2

线路,带宽质量优秀

| 名称 | CPU | RAM | 硬盘 | 带宽 | 月流量 | 价格 | 购买链接 |

|---|---|---|---|---|---|---|---|

| 韩国CN2(弹性) | 1 – 32C | 1 – 128G | 20 – 100G | 3 – 20Mbps | 看需求 | ¥ 35.00 起/ 月 | 点我购买 |

| 韩国CN2大带宽(弹性) | 1 – 32C | 1 – 128G | 20 – 100G | 20 – 50Mbps | 300G/月起 | 38 元/月起 | 点我购买 |

美国VPS

美国T级防御云服务器介绍

去程普通线路,回程CN2/9929线路,大陆防御值为200G,超过峰值解封快。

| 名称 | CPU | RAM | 硬盘 | 带宽 | 月流量 | 价格 | 购买链接 |

|---|---|---|---|---|---|---|---|

| 美国T级防御(弹性) | 1 – 16C | 1 – 16G | 20 – 100G | 20 – 300Mbps | 不限流 | 40 元/月起 | 点我购买 |

| 美国高防(弹性) | 1 – 16C | 1 – 16G | 20 – 200G | 10 – 30Mbps | 不限流 | 58 元/月起 | 点我购买 |

| 美国高防大带宽(弹性) | 1 – 16G | 1 – 16G | 20 – 200G | 20 – 50Mbps | 500G/月 | 56 元/月起 | 点我购买 |

安装使用方法

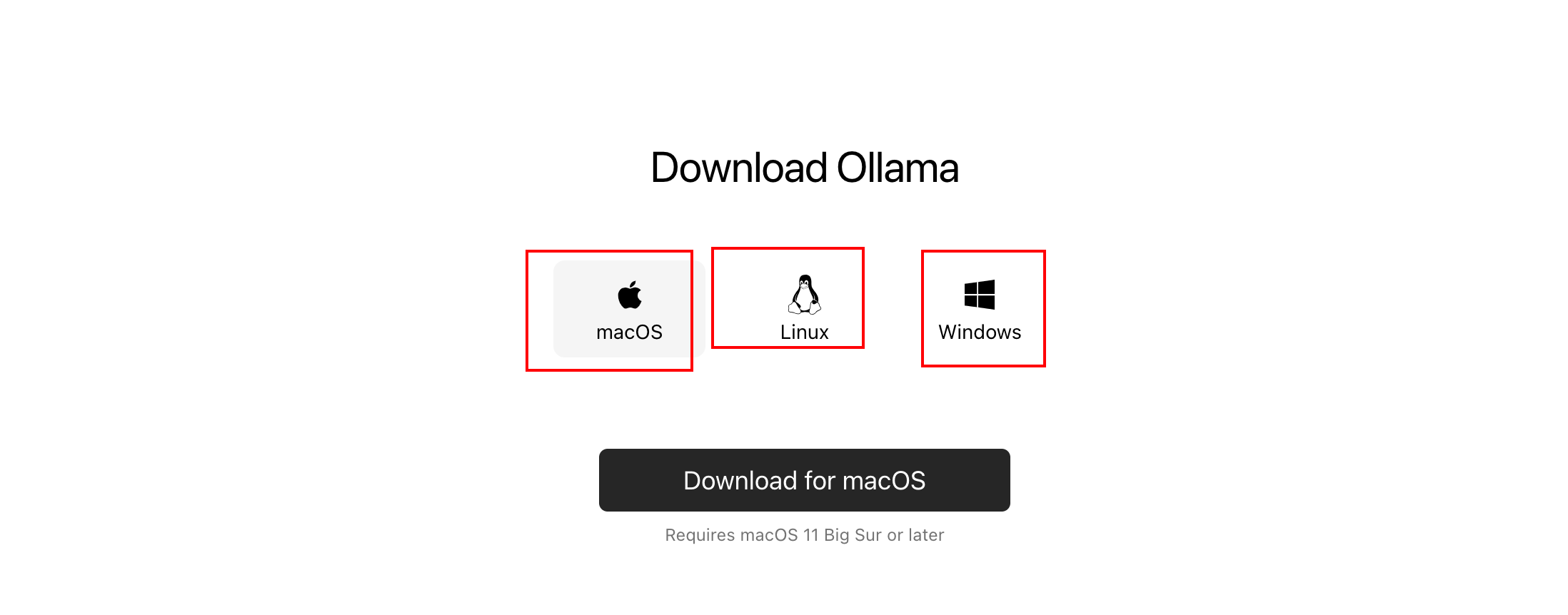

1.在ollama官网下载适合自己系统的版本

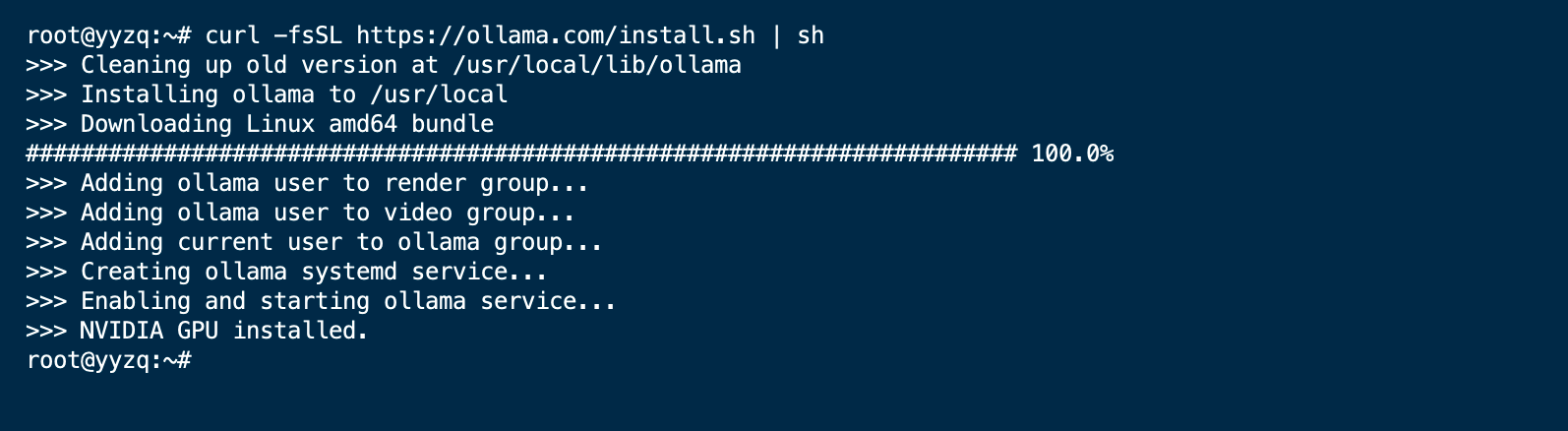

linux直接运行命令

curl -fsSL https://ollama.com/install.sh | sh

Linux系统

安装完是这样的

Windows系统直接运行

Mac系统安装完直接后台运行

2.安装需要的模型

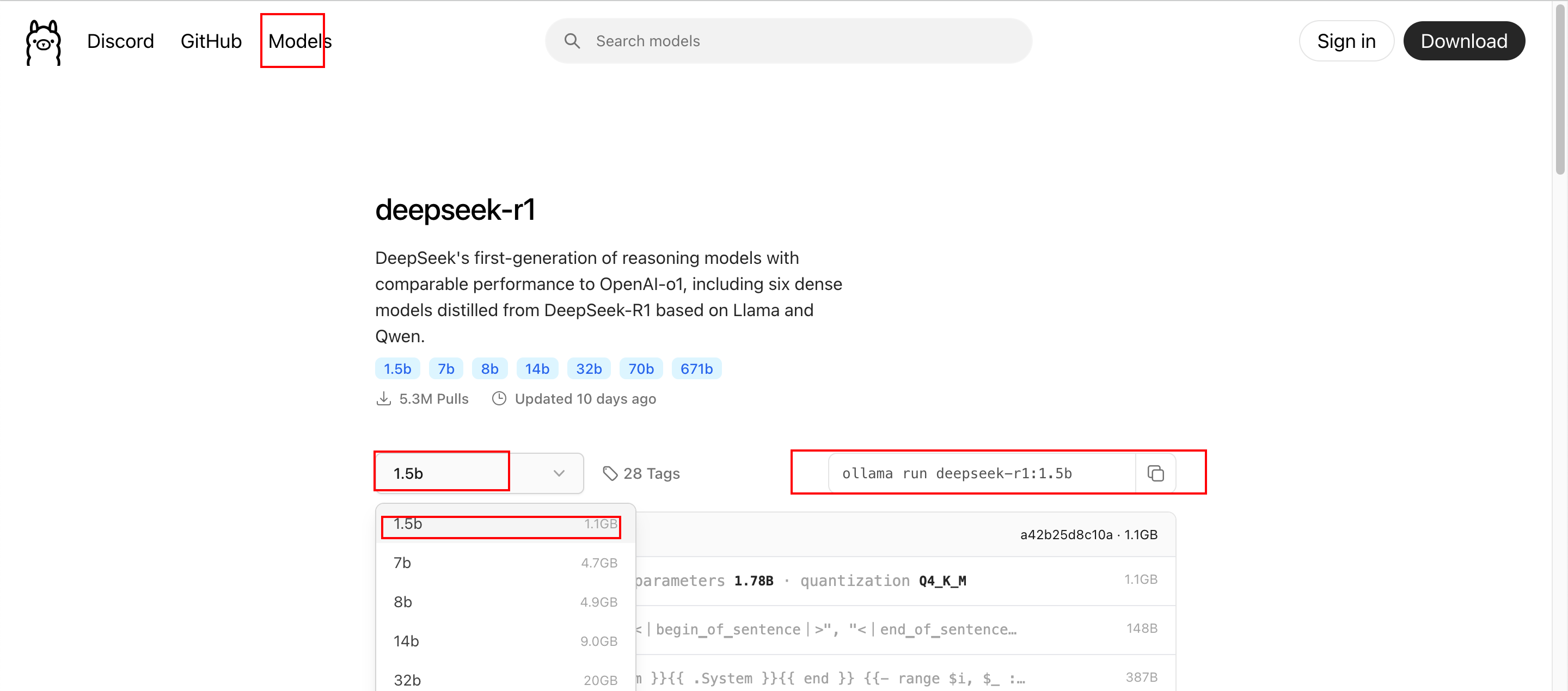

根据自己电脑的配置选择合适的模型

由于我电脑配置低就选择最小的版本

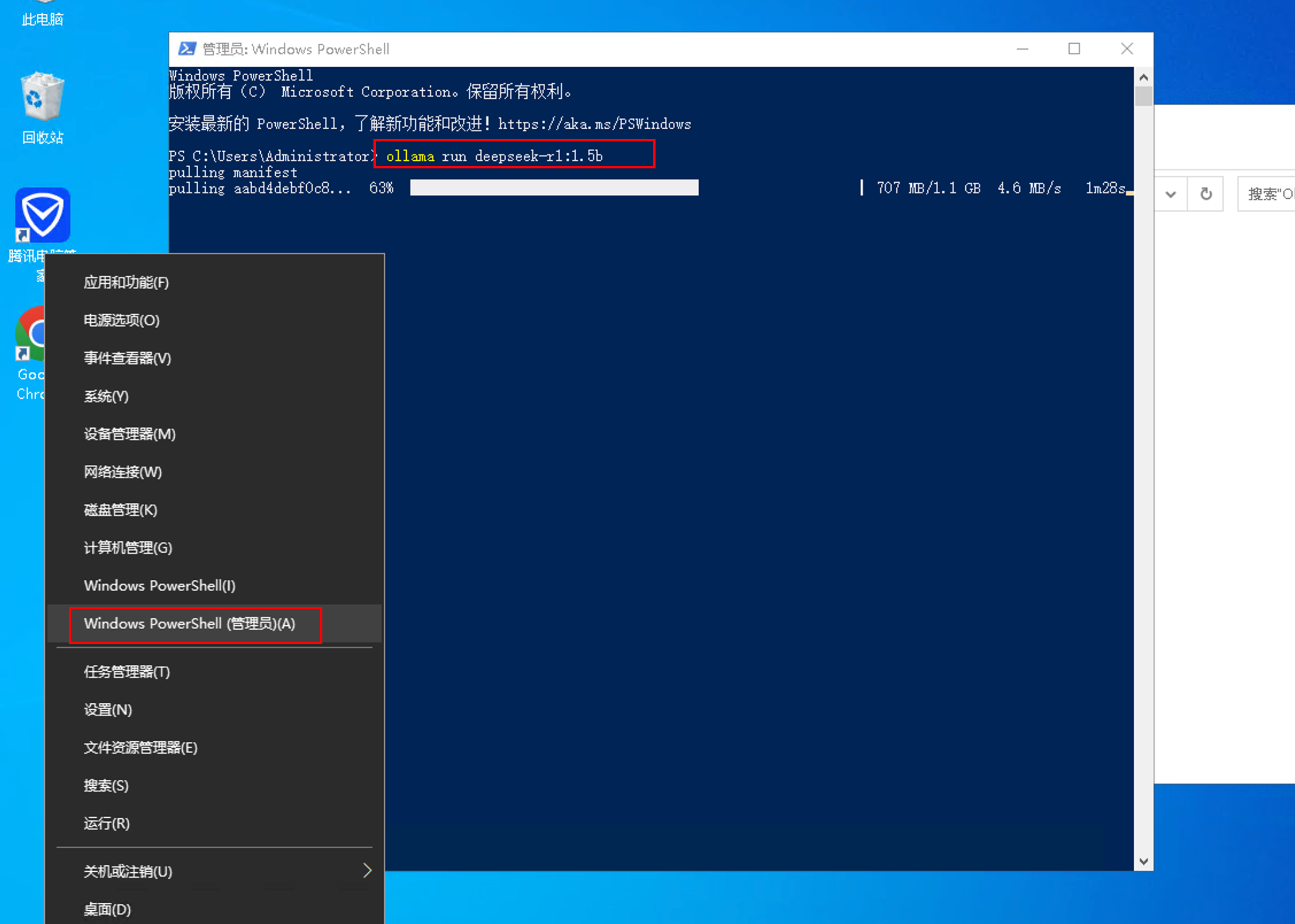

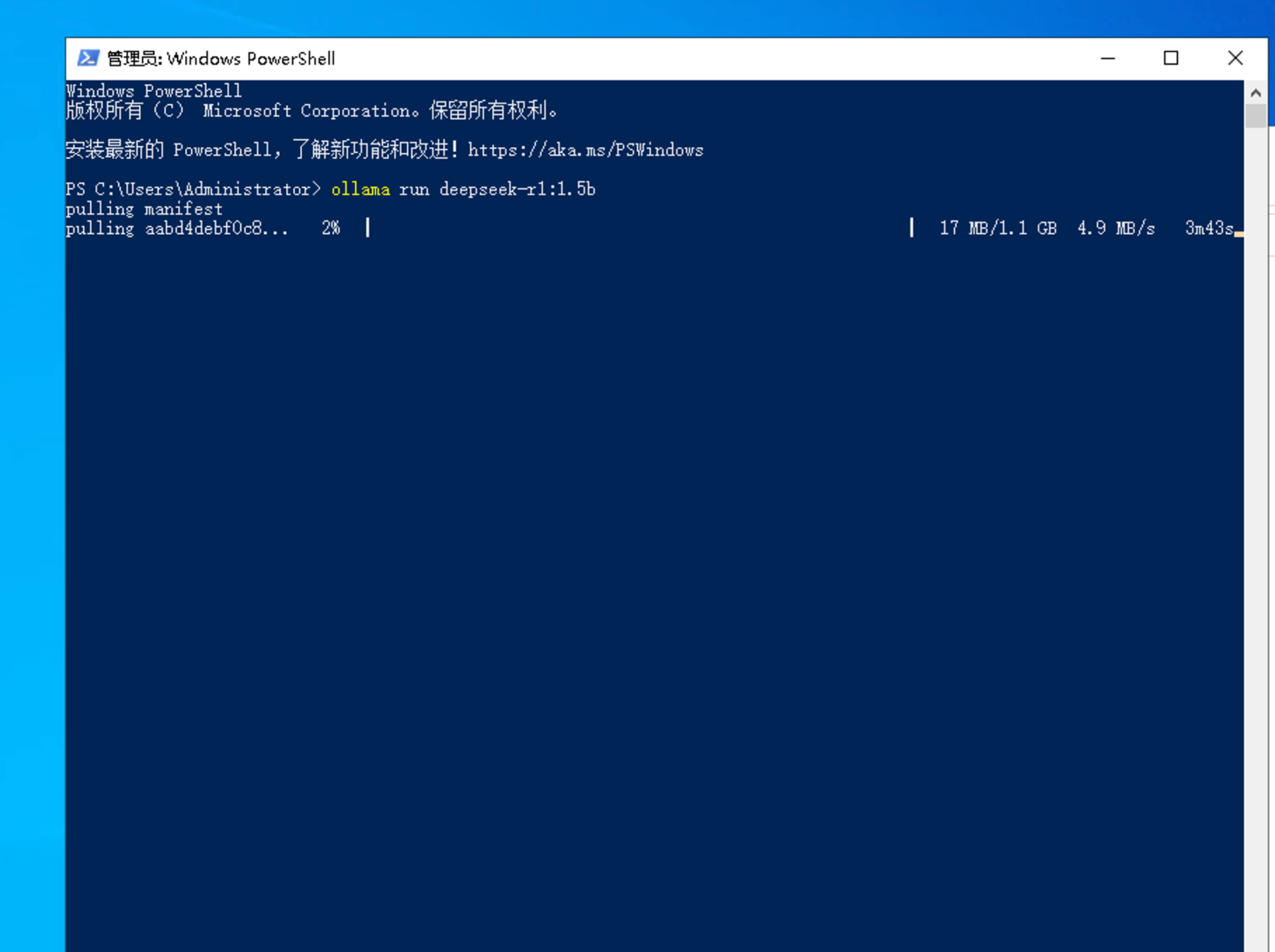

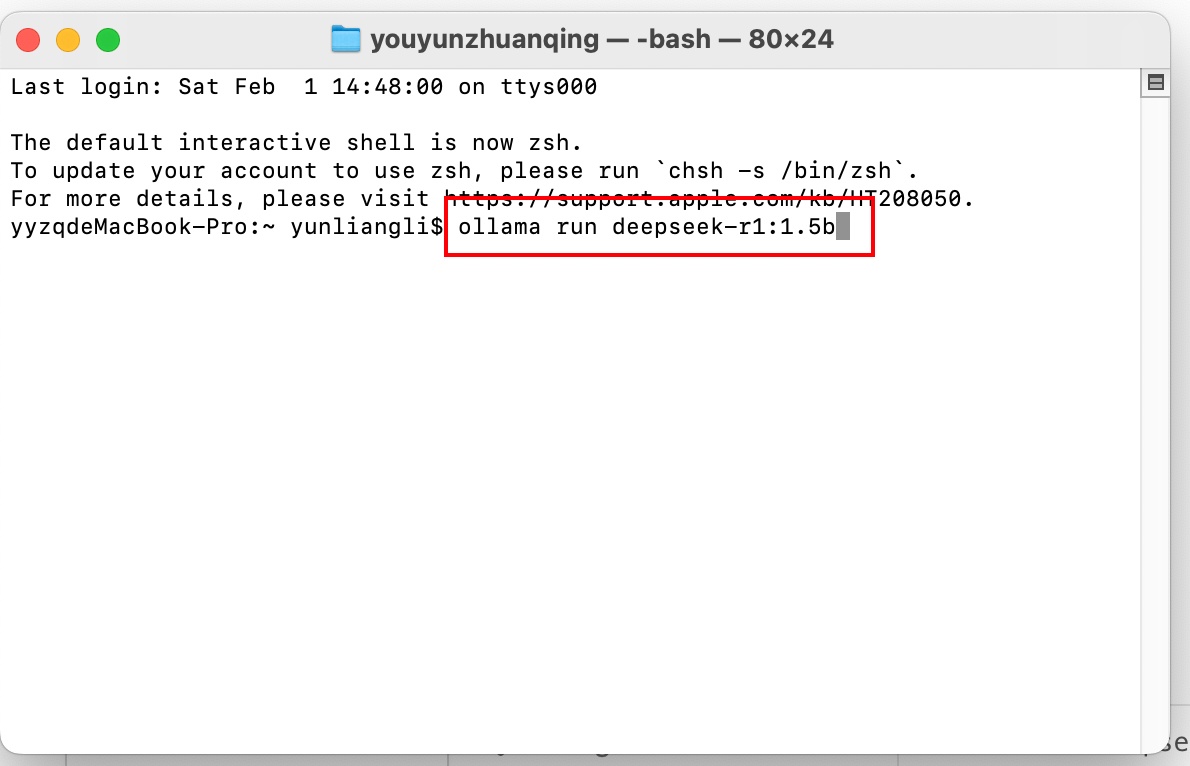

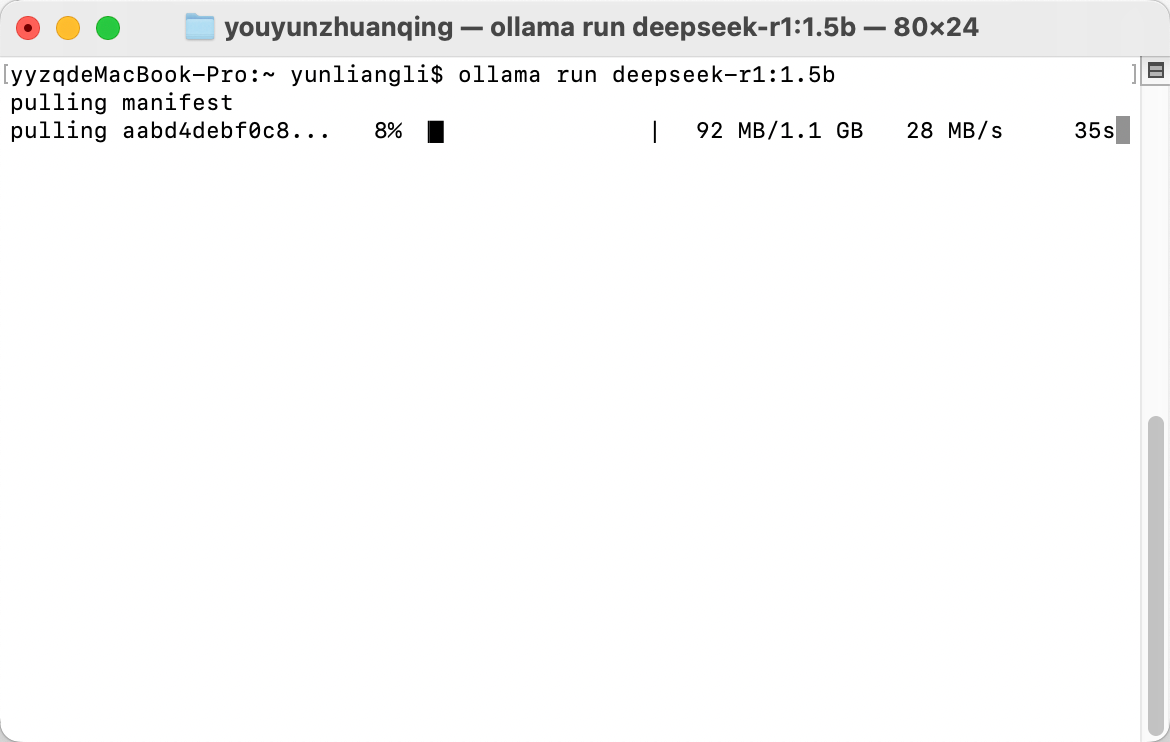

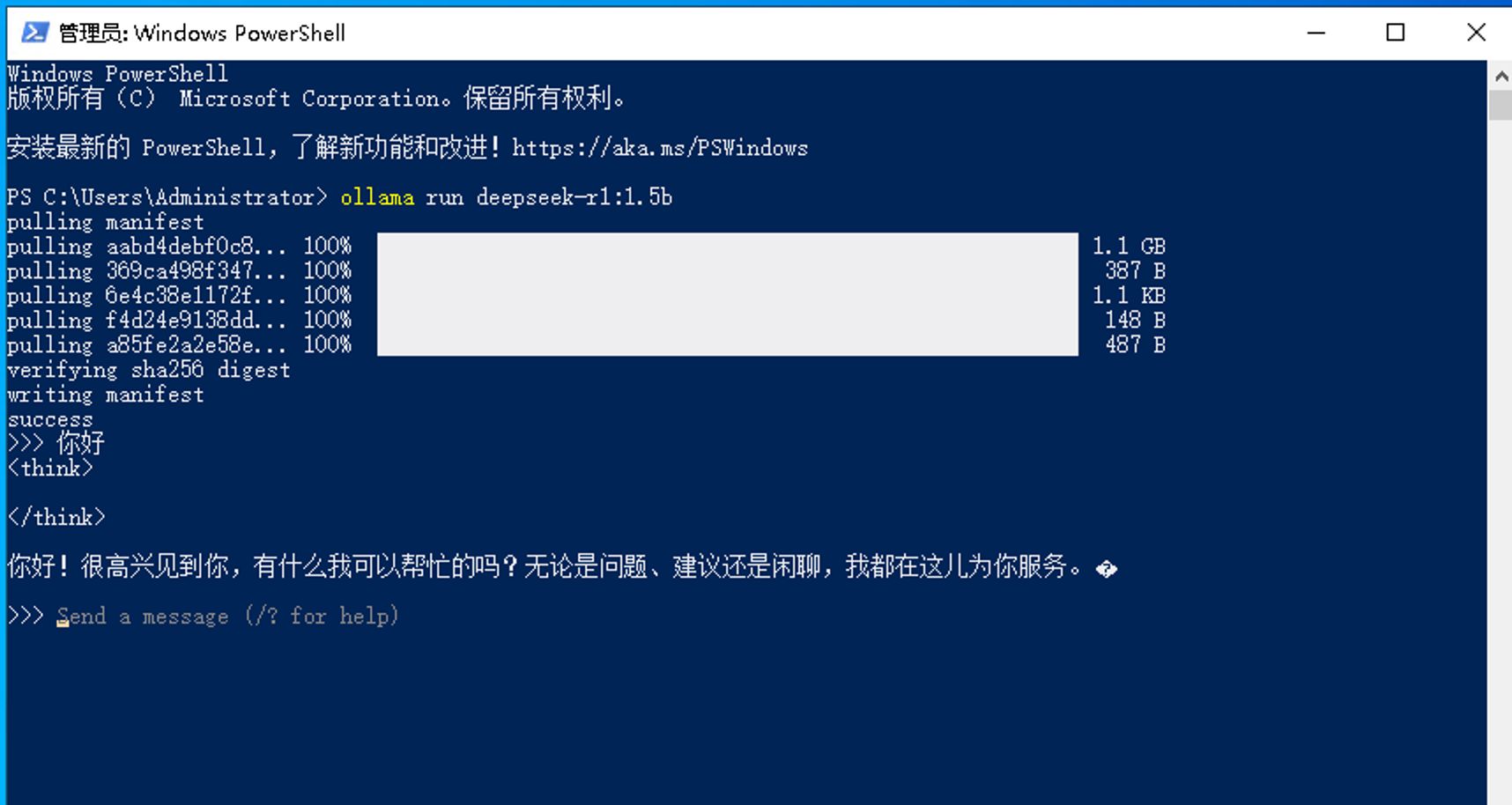

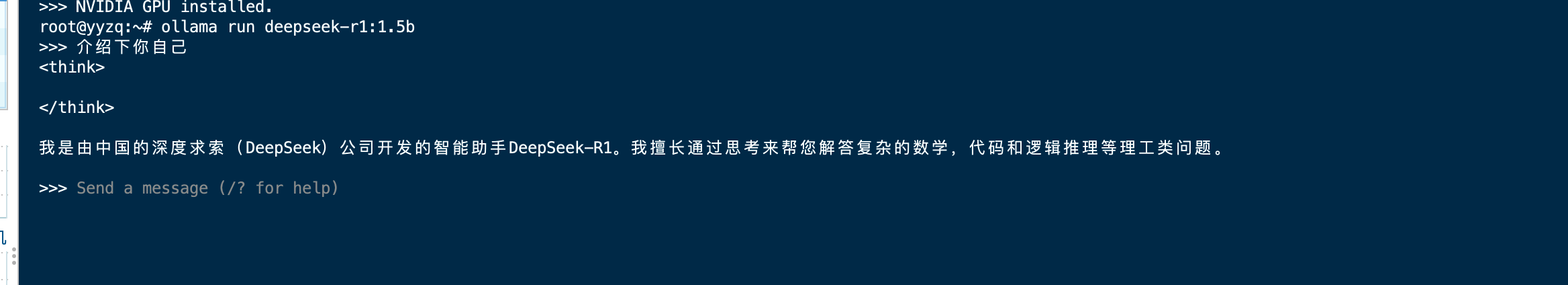

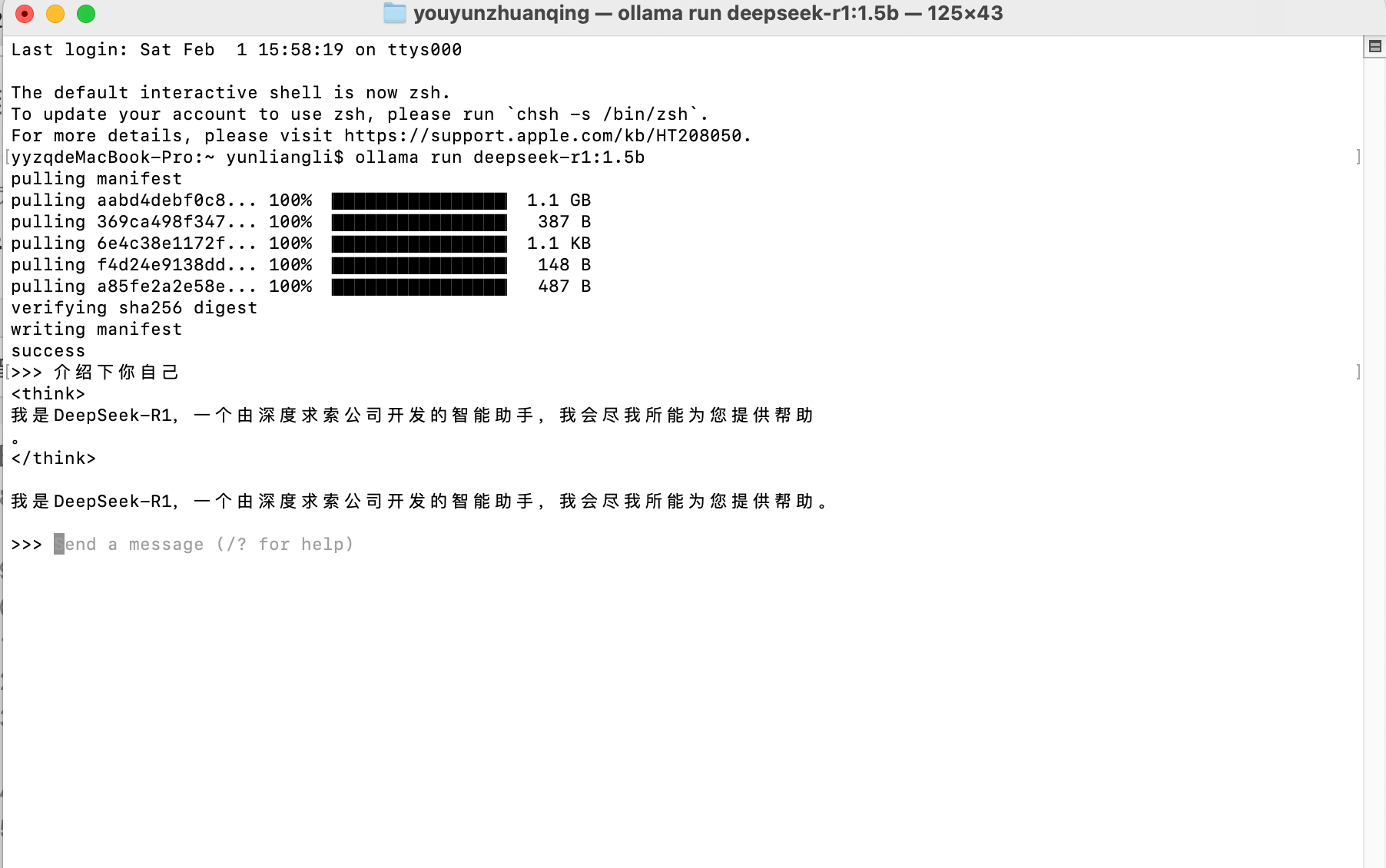

ollama run deepseek-r1:1.5b

Windows系统

Windows电脑打开Windows PowerShell执行命令

Mac系统

Mac电脑打开自带的终端

Linux系统

直接运行命令即可

3.使用方法

默认都可以直接在终端使用

比如

Windows

Linux

Mac

实用的技巧

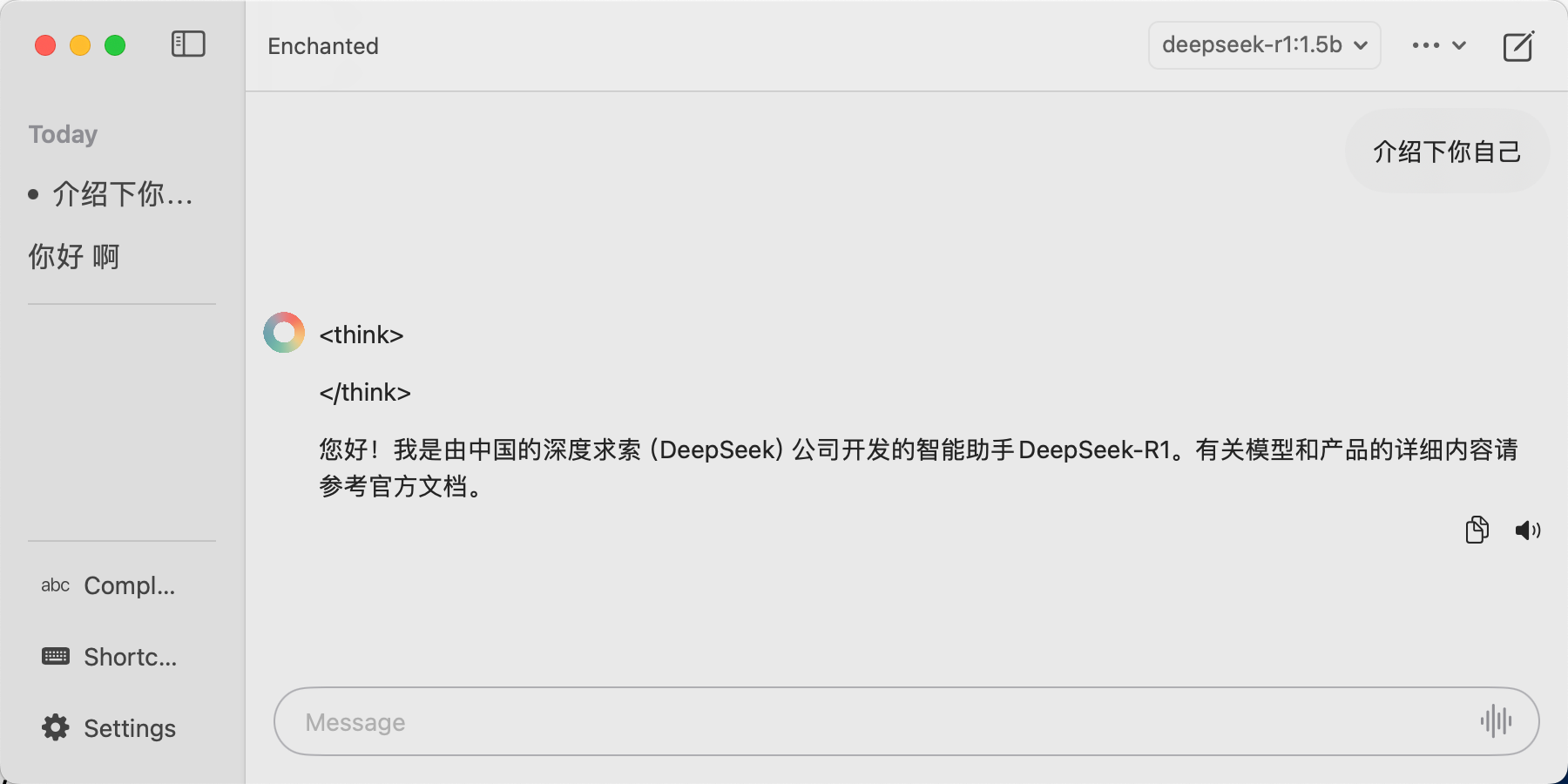

Mac系统可以使用这个软件直接使用

Enchanted

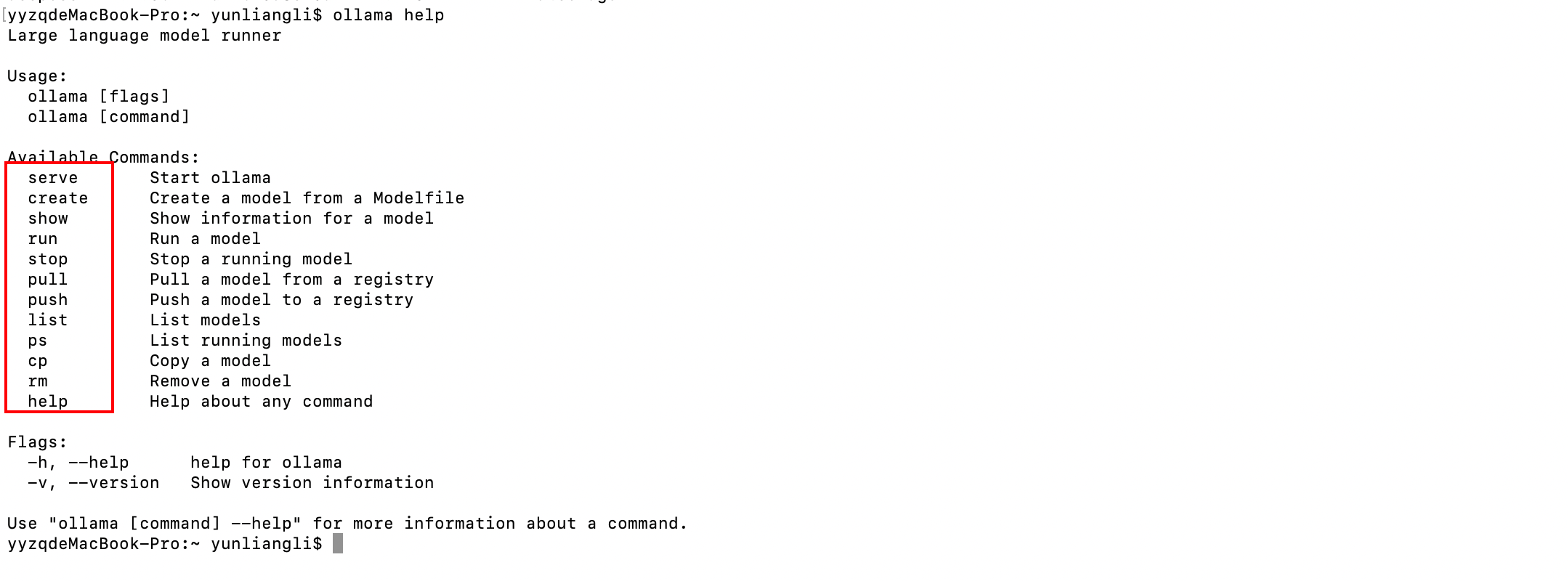

Ollama其他命令

1.列出本地的现有模型

ollama list

2.删除模型

ollama rm 模型名称

例如

ollama rm deepseek-r1:1.5b

3.其他输入ollama help获取

评论区